Datele sunt folosite din ce în ce mai mult pentru a guverna știința. Evaluările cercetării care erau făcute odinioară după nevoi și de către colegi, acum se fac uzual pe baza metricilor1. Problema este că evaluarea este acum făcută în baza datelor și nu a analizei. Metricile au proliferat: în genere bine intenționate, nebeneficiind de fiecare dată de cele mai bune informații, de cele mai multe ori prost aplicate. Riscăm să stricăm sistemul cu fiecare instrument gândit să-l îmbunătățească de vreme ce evaluarea este implementată de organizații care nu au cunoaștere de, sau sunt avizate asupra bunelor practici și a interpretării.

Înainte de 2000 exista Science Citation Index pe CD-ROM de la ISI - Institute for Scientific Information, care era folosit de toți experții pentru analize specializate. În 2002, Thompson Reuters a lansat o platformă web integrată prin care deschide larg baza de date Web of Science. Indici de citare concurenți au fost creați de: Scopus de la Elsevier (inițiat în 2004) și Google Scholar (versiunea beta în 2004). Au fost introduse instrumente bazate pe tehnologii web pentru a compara productivitatea instituțională și impactul, cum sunt InCites (care folosește Web of Science) și SciVal (care folosește Scopus), dar și software care să analizeze profile de citare individuale care folosesc Google Scholar (Publish or Perish, inițiat în 2007).

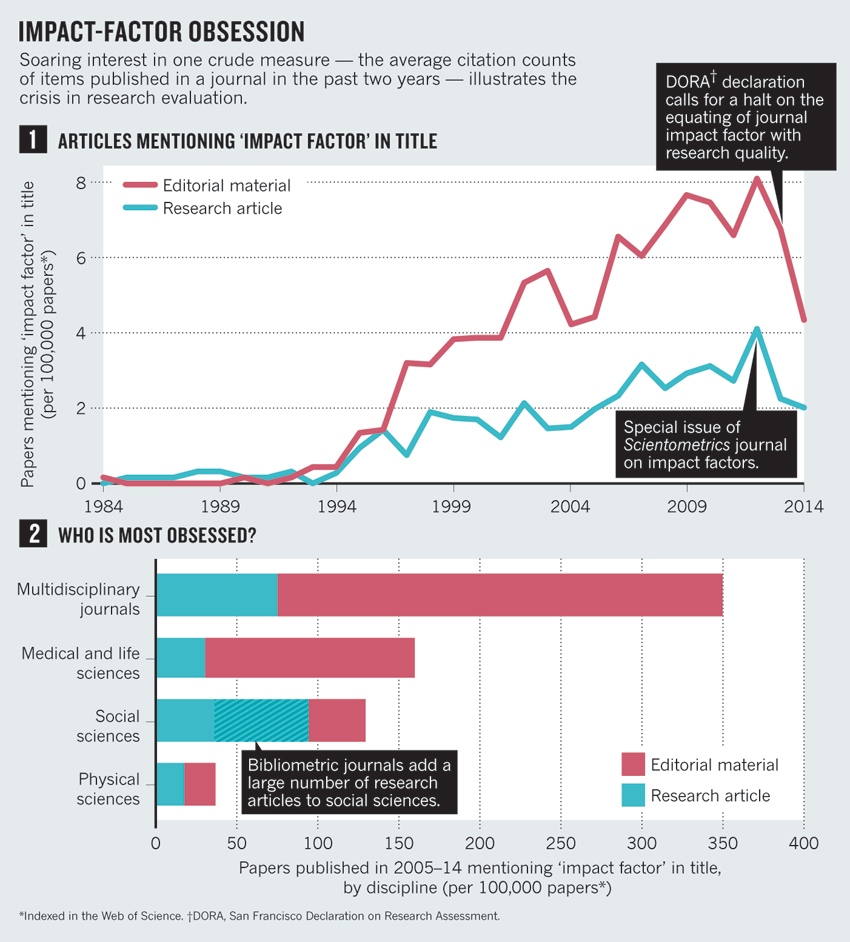

În 2005, Jorge Hirsch, un fizician de la Universitatea din California, San Diego, a propus h-index, făcând cunoscută numărarea citărilor pentru fiecare cercetător. Interesul pentru reviste a crescut constant după 1995 (vezi „”).

Mai târziu, au prins aderență metrici legate de utilizarea socială și comentariile online -- F1000Prime a fost inițiată în 2002, Mendeley în 2008 și (sprijinit de Macmillan Science and Education, care deține Nature Publishing Group), în 2011.

Ca scientometricieni, cercetători în domeniul social și administratori ai cercetării, am urmărit cu îngrijorare crescută proasta interpretare generală a indicatorilor de evaluare a performanței științifice. Următoarele sunt doar câteva din numeroasele exemple. În întreaga lume, universitățile au devenit obsedate de poziția în clasamentele mondiale (cum este Shanghai Ranking și lista de la Times Higher Education), chiar și când aceste liste se bazează pe ceea ce, în viziunea noastră, sunt date inexacte și indicatori arbitrari.

Unii recrutori cer valori ridicate ale h-indexului candidaților. Unele universități își fundamentează deciziile de promovare pe valori prag ale h-index și pe numărul de articole din revistele cu „impact mare”. CV-urile cercetătorilor au devenit oportunități de a crește aceste punctaje, mai ales în biomedicină. Peste tot supervizorii cer studenților la doctorat să publice în reviste cu impact mare și să facă rost de finanțare externă înainte de a fi gata.

În Scandinavia și China, unele universități alocă finanțare cercetării sau bonusuri pe baza unui număr: de exemplu, prin calcularea punctajelor individuale pentru alocarea „resurselor de performanță” sau prin oferirea cercetătorului unui bonus pentru publicarea într-o revistă cu un impact mai mare de 15 (ref. 2).

În multe cazuri, cercetătorii și evaluatorii încă exercită o evaluare echilibrată. Totuși, abuzul de metrici pentru cercetare a devenit prea larg răspândit pentru a mai fi ignorat.

Astfel, noi prezentăm Manifestul de la Leiden, numit după conferința care l-a cristalizat (vezi ). Cele zece principii ale sale nu sunt noutăți pentru scientometricieni, chiar dacă niciunul dintre noi nu ar putea să le rostească în întregime din pricina codificării care a lipsit până acum. Fruntașii domeniului cum ar fi Eugene Garfield (fondatorul ISI), au rămas în memorie afirmând aceste principii 3, 4. Dar aceștia nu sunt în cameră atunci când evaluatorii raportează administratorilor universității, care nu sunt experți în metodologile cu relevanță.

Cercetătorii care caută literatura cu care să conteste o evaluare, găsesc materiale împrăștiate în ceea ce sunt pentru ei reviste obscure la care nu au acces.

Noi oferim o distilare a celor mai bune practici în evaluarea bazată pe metrici pentru ca cercetătorii să poată cere socoteală evaluatorilor iar evaluatorii să poată analiza proprii indicatori.

Zece principii

1) Evaluarea cantitativă ar trebui să sprijine evaluarea expertă calitativă. Metricile cantitative pot contesta tendințele de influiențare din evaluarea colegială și pot ușura deliberarea. Aceasta ar trebui să întărească evaluarea colegială deoarece a face aprecieri privind colegii este dificil fără o gamă de informații relevante. Totuși, evaluatorii nu trebuie să cadă în tentația de a ceda procesul decizional numerelor. Indicatorii nu trebuie să se substituie judecății informate. Toată lumea deține responsabilitatea pentru propriile aprecieri.

2) Măsoară performanța în funcție de misiunea de cercetare a instituției, a grupului sau a cercetătorului. Obiectivele programului trebuie menționate de la început iar indicatorii utilizați pentru evaluarea performanței ar trebui să fie legați clar de acele obiective. Alegerea indicatorilor și modul în care sunt utilizați, ar trebui să ia în considerare contextele socio-economice și culturale lărgite. Oamenii de știință au diferite misiuni de cercetare. Cercetarea care lărgește frontierele cunoașterii științifice, diferă de cercetarea care este focalizată pe soluții oferite problemelor sociale. Evaluarea trebuie să se bazeze mai mult pe merite relevante politicii, industriei și publicului decât pe idei de excelență. Niciun model de evaluare nu se aplică tuturor contextelor.

3) Protejați excelența în cercetarea relevantă locală. În multe părți ale lumii, excelența în cercetare este egal cu publicarea în limba engleză. Legislația spaniolă, de exemplu, afirmă dorința ca oamenii de știință spanioli să publice în registe cu impact mare. Factorul de impact este calculat pentru revistele indexate în Web of Science bazat în Statele Unite ale Americii și în limba engleză. Aceste influiențe sunt problematice mai ales în științele sociale și umanioare, unde cercetarea este mult mai angajată la nivel regional și național. Multe alte domenii au dimensiuni naționale sau regionale - de exemplu, epidemiologia HIV din Africa Subsahariană.

Acest pluralism și relevanța socială tind să fie suprimate pentru a creea articole de interes pentru gardienii marelui impact: revistele în limba engleză. Sociologii spanioli care sunt citați des în Web of Science au lucrat pe modele abstracte sau pe date din Statele Unite. Este pierdută specificitatea sociologilor din revistele spaniole cu impact mare: subiecte precum legea muncii la nivel național, asistență medicală familială pentru bătâni sau angajarea imigranților5. Metricile construite pe literatura de înaltă calitate alta decât în engleză ar putea servi la identificarea și răsplătirea excelenței în cercetarea locală cu relevanță.

4) Mențineți colecțiile de date și procesele analitice deschise, transparente și simple. Construcția bazelor de date necesare evaluării ar trebui să urmeze reguli clar enunțate înainte de încheierea cercetării. Aceasta a fost practica generală între grupurile academice și cele comerciale care au elaborat metodologia de evaluare bibliometrică de-a lungul a câtorva decade. Aceste grupuri au apelat la protocoale publicate în literatura evaluată colegial. Această transparență a permis observarea. De exemplu, în 2010, dezbaterea publică privind caracteristicile tehnice a unui indicator important folosit de unul dintre grupurile noastre (Centrul pentru Studii în Tehnologie și Știință a Universității din Leiden, Olanda), a condus la revizuirea calculării acestui indicator6. Cei mai noi intrați din domeniul comercial ar trebui să respecte aceleași standarde; nimeni nu ar trebui să accepte o mașină de evaluare tip cutie neagră.

Simplitatea este o virtute în cazul unui indicator pentru că mărește transparența. Metricile simpliste pot distorsiona înregistrarea (vezi principiul 7). Evaluatorii trebuie să se străduiască pentru a găsi un echilibru - indicatori simpli fideli complexității procesului de cercetare.

5) Permiteți celor evaluați să verifice datele și analiza. Pentru a asigura calitatea datelor, toți cercetătorii incluși în studiile bibliometrice, ar trebui să poată verifica dacă propriile rezultate au fost identificate corect. Oricine care direcționează și gestionează procesele de evaluare, ar trebui să asigure acuratețea datelor prin auto-verificare sau auditare cu terți. Universitățile ar putea implementa acest lucru în sistemele de informare pentru cercetare proprii și ar trebui să fie un principiu director în selectarea celor care oferă astfel de sisteme. Pentru a aduna și procesa date precise de înaltă calitate ia timp și bani. Bugetați acest lucru.

6) Țineți cont de diferențele între domenii privind practicile de publicare și citare. Cea mai bună practică este să selectați o suită de indicatori posibili și să permiteți domeniilor să aleagă dintre ele. Câțiva ani în urmă, un grup de istorici europeni au primit un punctaj scăzut într-o evaluare națională colegială deoarece au scris cărți și nu articole în reviste indexate de Web of Science. Istoricii au avut nenorocul să facă parte din departamentul de psihologie. Istoricii și cercetătorii din domeniul științelor sociale au nevoie să li se cuantifice cărțile și literatura în limba națională ca publicații; specialiștii din științele computerelor au nevoie să li se cuantifice articolele de conferință.

Ratele de citare variază după domeniu: revistele înalt cotate din matematică au factori de impact în jurul lui 3; revistele înalt cotate din biologia celulară au factori de impact peste 30. Sunt necesari indicatori normalizați iar cea mai robustă metodă de normalizare se bazează pe centile: fiecare lucrare este cântărită pe baza centilei căruia îi aparține în distribuția citărilor din domeniul propriu (la vârf 1%, 10% sau 20 de exemplu). O singură publicație foarte citată înbunătățește ușor poziția universității într-un clasament care este bazat pe indicatori centile, dar poate propulsa universitatea de la mijloc la vârful unui clasament construit pe medii de citare7.

7) Bazați-vă evaluarea fiecărui cercetător pe o judecată calitativă a portofoliului. Cu cât ești mai în etate, cu atât h-index-ul este mai mare chiar și în absența unor lucrări noi. H-index variază în funcție de domeniu: cercetătorii din domeniul științelor vieții ajung la 200; fizicienii la 100 iar științele sociale la 20-30 (ref. 8). Ține de baza de date: există cercetători în științele computerelor care au un h-index în jur de 10 în Web of Science, dar 20-30 în Google Scholar9. Lecturarea și evaluarea muncii unui cercetător sunt mult mai adecvate față de încrederea într-un singur număr. Chiar și când se compară foarte mulți cercetători, o abordare care ia în considerare mai multe informații despre expertiza, experiența, activitatea și influiența personală este cea mai bună.

8) Evitați certitudinile nefundamentate și falsa precizie. Indicatorii privind știința și tehnologia sunt supuși ambiguității și incertitudinii și necesită aserțiuni puternice, care nu sunt universal acceptate. De exemplu, înțelesul citărilor a fost îndelung dezbătut. Astfel, bunele practici folosesc indicatori multipli pentru a oferi o imagine multilaterală și robustă. Dacă pot fi cuantificate incertitudinea și eroarea, de exemplu cu ajutorul unor bare reprezentând eroarea, această informație ar trebui să însoțească valorile publicate ale indicatorilor. Dacă acest lucru nu este posibil, cei care produc indicatorii ar trebui, cel puțin să evite falsa precizie. De exemplu, factorul de impact al revistei este publicat cu trei mantise zecimale pentru a evita situațiile de baraj. Totuși, dată fiind ambiguitatea conceptuală și variabilitatea aleatorie a numărului citărilor, nu are sens să se facă comparații între reviste pe baza unor diferențe nesignificative ale factorului de impact. Evitați falsa precizie: doar un zecimal este garantat.

9) Recunoașteți efectele sistemice ale evaluării și a indicatorilor. Indicatorii modifică sistemul prin stimulentele pe care le stabilesc. Aceste efecte ar trebui să fie anticipate. Acest lucru înseamnă că o suită de indicatori este întotdeauna preferată - unul singur invită la vânătoare și o alunecare a obiectivelor (prin care măsurătorile devin ținta). De exemplu, în anii 90, Australia a finanțat cercetarea universitară folosind o formulă bazată în mare parte pe numărul de articole publicate de un institut. Universitățile ar putea calcula „valoarea” unui articol dintr-o revistă cu multe citări; în anul 2000, aceasta era de 800 de dolari australieni (aproape 480 de dolari americani în 2000), reflectat în finanțarea cercetări. Previzibil, numărul artcolelor publicate de cercetarea australiană a crescut, dar acestea erau publicate în reviste mai puțin citate, ceea ce sugerează o scădere în calitarea articolelor10.

10) Examinați regulat indicatorii și actualizați-i. Misiunile de cercetare și obiectivele evaluării sunt schimbătoare iar însăși sistemul de cercetare în sine evoluează simultan. Metricile utile odinioară, devin neadecvate; apar unele noi. Sistemele de indicatori trebuie să fie revizuite și probabil modificate. Înțelegând efectele formulei simple, în anul 2010, Australia a introdus inițiativa Excelență în Cercetarea Australiană, care pune accentul pe calitate.

Pașii următori

Urmând aceste zece principii, evaluarea cercetării poate juca un rol important în progresul științei și a interacțiilor sale cu societatea. Metricile de cercetare pot oferi informații esențiale care ar fi greu de strâns sau înțeles prin expertiză individuală. Dar informațiile cantitative nu trebuie să li se permită transformarea din instrument în țintă.

Cele mai bune decizii sunt luate prin combinarea statisticilor robuste fiind atenți la obiectivele și natura cercetării care este evaluată. Dovezi cantitative și calitative sunt necesare, fiecare în felul său fiind obiective. Procesul decizional referitor la știință trebuie să se bazeze pe procese de înaltă calitate care beneficiază de informații prin date de cea mai mare calitate.

Nature 520, 429–431 (23 April 2015) doi:10.1038/520429a

- Wouters, P. in Beyond Bibliometrics: Harnessing Multidimensional Indicators of Scholarly Impact (eds Cronin, B. & Sugimoto, C.) 47–66 (MIT Press, 2014).

- Shao, J. & Shen, H. Learned Publ. 24, 95–97 (2011).

- Seglen, P. O. Br. Med. J. 314, 498–502 (1997).

- Garfield, E. J. Am. Med. Assoc. 295, 90–93 (2006).

- López Piñeiro, C. & Hicks, D. Res. Eval. 24, 78–89 (2015).

- van Raan, A. F. J., van Leeuwen, T. N., Visser, M. S., van Eck, N. J. & Waltman, L. J. Informetrics 4, 431–435 (2010).

- Waltman, L. et al. J. Am. Soc. Inf. Sci. Technol. 63, 2419–2432 (2012).

- Hirsch, J. E. Proc. Natl Acad. Sci. USA 102, 16569–16572 (2005).

- Bar-Ilan, J. Scientometrics 74, 257–271 (2008).

- Butler, L. Res. Policy 32, 143–155 (2003).